近日,權威機構ACM MM’20 Grand Challenge主辦的“大規模復雜場景人體視頻解析”挑戰賽如期舉行,包括 Amazon、騰訊、大華科技、依圖科技、中山大學等上百支參賽隊伍參與了超過56000個復雜事件下的人體行為(包括排隊、打架、俯身、同行、跑動、滯留等)解析。來自中國的依圖科技拿下了“Track-4:行為識別”的第一名。

據了解,ACM是全球最大的計算機領域專業性學術組織,其評選的圖靈獎(A.M.Turing Award)被公認為世界計算機領域的諾貝爾獎。而ACM MM是全球多媒體領域的頂級會議,屬中國計算機學會(CCF)指定的A類國際會議。

如果把人臉識別比作醫院的“普外門診”,那么行為識別尤其是人類的行為識別,其復雜度和識別難度不亞于“心血管內科+神經內科”。場景復雜多變、動作差異化大、需要捕捉連續動作和長時間動作,這些對行為識別和分析都有著巨大的挑戰,也就需要算法對行為本身有更精準的分析推理能力,甚至還能通過既定的場景推算未曾見過的場景。

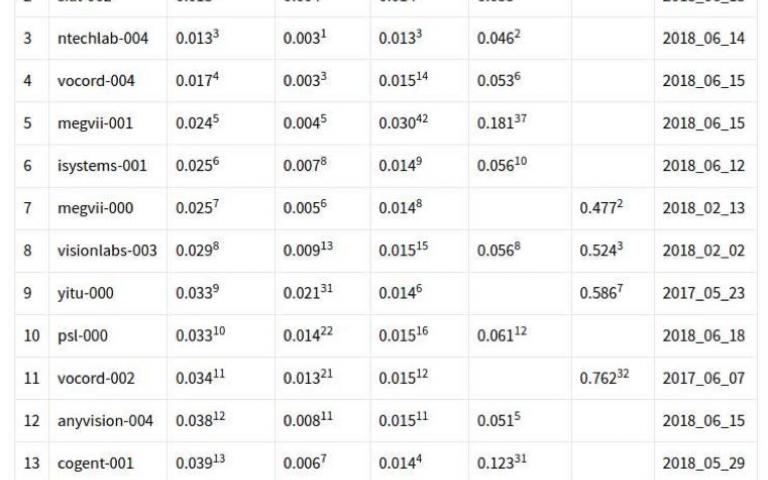

依圖方面介紹,在比賽中,依圖算法的指標達到了wf-mAP@avg 0.26,將以往學術界中的基準算法提升了近3倍。與舉辦了多次的國際競賽不同,這次競賽是首屆,參賽隊伍在賽前也無法了解識別的類別、數據集的大小和識別的具體需求,要在短短一個多月的時間內,設計出最優的算法。

首先,視頻相較于圖像的行為識別更加復雜,且如何建模、視頻幀之間的相關性仍是學術界一直存在的難題。當應用場景明確后,在已知分析的對象是人體且明確知道要識別的類別后,就可以針對性的進行算法優化,通過算法定制化來提升算法性能,解決以往不能很好解決的問題。

與此同時,依圖此次創新性地將算法與場景進行了深度結合。一方面從視頻中自動提取到了準確豐富的場景信息,結合先進的行人檢測、行人重識別算法,全面構建了人與人、人與場景、人與物之間在視頻中的關系;另一方面,借助多年來的算法積淀和對行業場景的理解,依圖對比賽中要求的特定的14類任務進行了深度算法優化。

值得關注的是,不同于其他參賽隊伍,依圖此次沒有使用復雜的多模型融合策略,僅用單模型,借助背景提取和分割算法,將行為的解析與場景結合,大大降低了問題難度,這也意味著仍可以進一步通過融合多個模型提升算法性能。

您可以復制這個鏈接分享給其他人:http://www.jisvip.com/node/868